ChatGPT’ye bir soru sordun, gayet akıcı ve güvenilir görünen bir cevap aldın. Ama sonra fark ettin ki verilen kaynak aslında yok, bahsedilen istatistik tamamen uydurma ya da tarih yanlış. İşte bu duruma AI hallucination (yapay zeka halüsinasyonu) deniyor. Yapay zeka araçları hayatımıza hızla girerken, bu “uydurma” yanıtları tanımak ve doğrulamak artık kritik bir beceri haline geldi.

Bu yazıda AI hallucination kavramını net bir şekilde açıklayacak, neden oluştuğunu anlatacak ve en önemlisi AI yanıtlarını doğrulamak için kullanabileceğin pratik bir kontrol listesi sunacağız. Böylece yapay zekadan aldığın bilgilere ne zaman güvenip ne zaman şüpheyle yaklaşman gerektiğini daha iyi anlayabilirsin.

Kısa Tanım: AI Hallucination Nedir?

AI hallucination, bir yapay zeka modelinin gerçek olmayan, yanlış veya tamamen uydurma bilgiler üretmesine verilen isimdir. Model bunu yaparken son derece kendinden emin bir dil kullanır; bu da kullanıcının yanlış bilgiyi gerçekmiş gibi algılamasına neden olabilir.

Kilit Çıkarım: Halüsinasyon, AI’ın “bilmiyorum” demek yerine mantıklı görünen ama aslında yanlış bir cevap üretmesidir.

Örneğin bir dil modeline “X kitabının yazarı kim?” diye sorduğunda, model o kitabı hiç bilmese bile bir yazar ismi uydurabilir. Ya da var olmayan bir akademik makaleye atıf yapabilir. Bu durum özellikle araştırma, haber yazımı veya akademik çalışmalarda ciddi sorunlara yol açabilir.

AI Hallucination Neden Oluşur?

Yapay zeka modellerinin halüsinasyon üretmesinin birkaç temel nedeni var. Bunları anlamak, hangi durumlarda daha dikkatli olman gerektiğini bilmene yardımcı olur.

Eğitim Verisinin Sınırları

Dil modelleri belirli bir tarihe kadar olan verilerle eğitilir. Bu tarihten sonraki olaylar, yeni ürünler veya güncel gelişmeler hakkında bilgileri yoktur. Ancak model bunu açıkça söylemek yerine, mevcut bilgilerinden “tahmin” ederek cevap üretebilir.

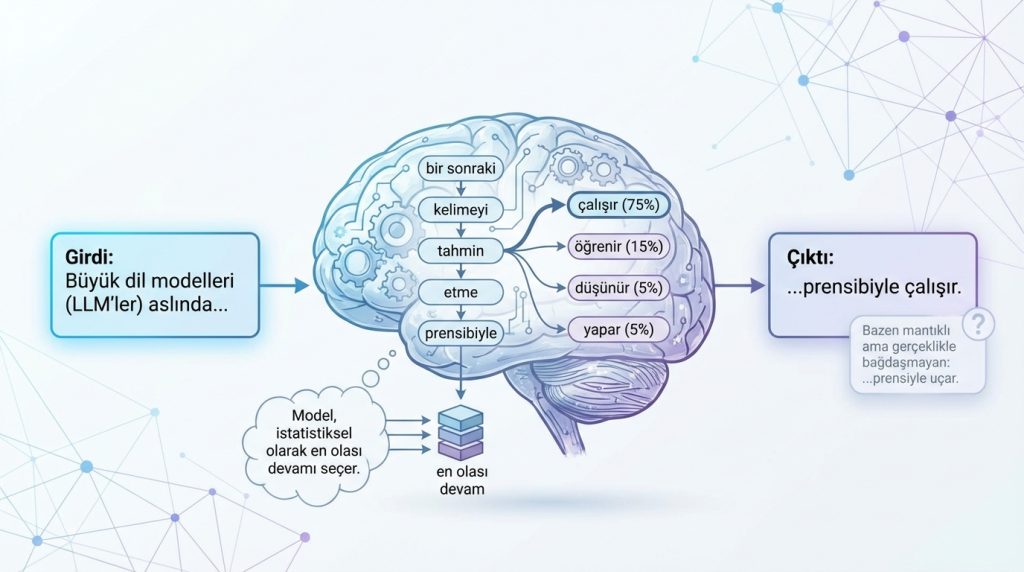

Olasılık Tabanlı Çalışma Mantığı

Büyük dil modelleri (LLM’ler) aslında bir sonraki kelimeyi tahmin etme prensibiyle çalışır. Model, istatistiksel olarak en olası devamı seçer. Bu da bazen mantıklı görünen ama gerçeklikle bağdaşmayan cümleler üretmesine neden olur.

Belirsiz veya Karmaşık Sorular

Soru ne kadar belirsiz veya niş bir konuya dairsa, modelin doğru bilgiye sahip olma ihtimali o kadar düşer. Pratikte en sık görülen halüsinasyonlar şu alanlarda ortaya çıkar:

- Spesifik tarihler ve istatistikler

- Gerçek kişilerin biyografileri

- Akademik kaynaklar ve atıflar

- Teknik spesifikasyonlar ve fiyatlar

- Güncel olaylar ve haberler

Basit Örnek: Halüsinasyon Nasıl Görünür?

Diyelim ki bir AI aracına şunu sordun: “2019’da Türkiye’de en çok satan roman hangisiydi?” Model sana bir kitap ismi ve yazar adı verebilir. Cevap gayet inandırıcı görünür, hatta satış rakamları bile eklenmiş olabilir. Ancak bu bilgiyi doğrulamaya çalıştığında, o kitabın o yıl çıkmadığını ya da hiç var olmadığını keşfedebilirsin.

Başka bir senaryo: Bir yazılım kütüphanesi hakkında soru sorduğunda, model var olmayan bir fonksiyon adı veya yanlış bir parametre sıralaması verebilir. Kod çalışmaz ve sen saatlerce hata ayıklamaya çalışırsın.

Bu örnekler, AI yanıtlarını körü körüne kabul etmemenin ne kadar önemli olduğunu gösteriyor.

Benzer Kavramlarla Farkı

AI hallucination bazen başka kavramlarla karıştırılabiliyor. İşte aradaki farklar:

- Bias (Önyargı): Modelin eğitim verisindeki dengesizliklerden kaynaklanan sistematik eğilimlerdir. Halüsinasyon ise tamamen uydurma bilgi üretmektir.

- Hata (Error): Teknik bir aksaklık veya hesaplama yanlışıdır. Halüsinasyon ise modelin “bilmediğini bilmemesi” sonucu oluşur.

- Misinformation: Yanlış bilginin kasıtlı veya kasıtsız yayılmasıdır. AI halüsinasyonu kasıtlı değildir; model gerçekten “inanarak” yanlış bilgi üretir.

AI Yanıtlarını Doğrulama Kontrol Listesi

İşte AI’dan aldığın yanıtları değerlendirirken kullanabileceğin pratik bir kontrol listesi. Bu adımları takip etmek, halüsinasyonları yakalamanı kolaylaştırır.

1) Kaynağı Sor ve Doğrula

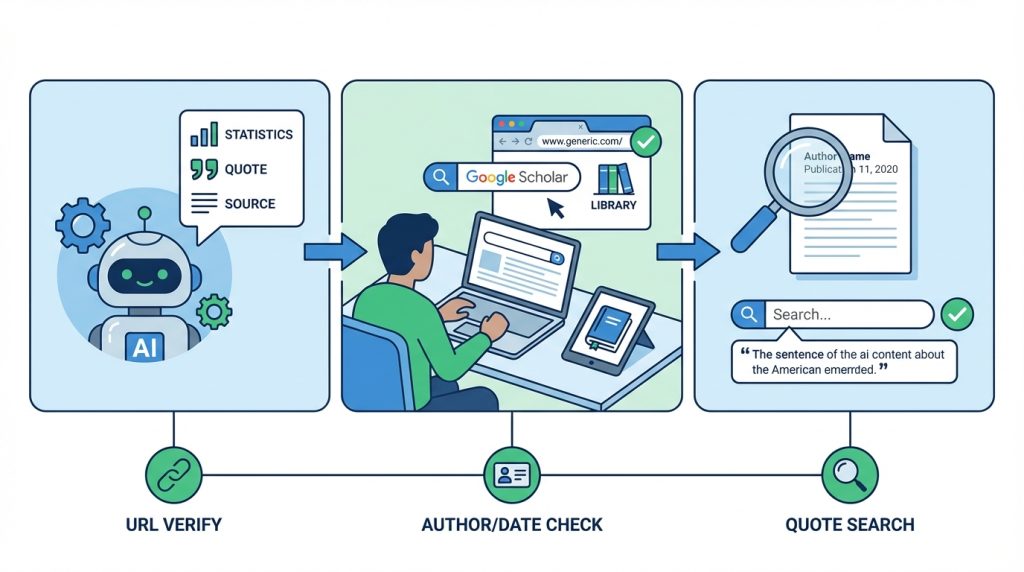

AI bir istatistik, alıntı veya kaynak veriyorsa, o kaynağın gerçekten var olup olmadığını kontrol et. Akademik makaleler için Google Scholar, kitaplar için kütüphane katalogları kullanabilirsin.

- Verilen URL’yi tarayıcıda aç ve sayfanın var olduğunu doğrula

- Yazar adını ve yayın tarihini çapraz kontrol et

- Alıntı yapılan cümleyi tırnak içinde arama motorunda ara

2) Tarihleri ve Rakamları Sorgula

Spesifik tarihler, fiyatlar ve istatistikler halüsinasyona en açık alanlardır. Özellikle şunlara dikkat et:

- Yuvarlak ve çok “temiz” görünen rakamlar şüpheli olabilir

- Güncel fiyatlar ve stok bilgileri için resmi siteleri kontrol et

- Tarihsel olayların tarihlerini Wikipedia veya ansiklopedilerden doğrula

3) Çapraz Kontrol Yap

Aldığın bilgiyi en az iki farklı güvenilir kaynaktan doğrula. Eğer bilgi sadece AI’ın verdiği yanıtta varsa ve başka hiçbir yerde bulamıyorsan, büyük ihtimalle halüsinasyondur.

4) Uzmanlık Gerektiren Konularda Ekstra Dikkatli Ol

Tıp, hukuk, finans gibi uzmanlık gerektiren alanlarda AI yanıtlarına özellikle temkinli yaklaş. Bu tür konularda AI’ın verdiği bilgiler genel niteliktedir ve profesyonel tavsiye yerine geçmez.

- Sağlık konularında mutlaka bir sağlık uzmanına danış

- Hukuki konularda avukata başvur

- Finansal kararlarda uzman görüşü al

5) Modelin Sınırlarını Bil

Kullandığın AI aracının eğitim verisi kesim tarihini öğren. Bu tarihten sonraki olaylar hakkında verilen bilgiler güvenilir olmayabilir. Ayrıca çok niş veya yerel konularda modelin bilgi eksikliği olabileceğini unutma.

6) Tutarsızlıkları Yakala

Aynı konuda farklı sorular sorarak yanıtların tutarlı olup olmadığını test edebilirsin. Eğer model aynı konu hakkında çelişkili bilgiler veriyorsa, bu bir halüsinasyon işareti olabilir.

7) Aşırı Kendinden Emin Dile Dikkat Et

AI modelleri genellikle belirsizlik ifade etmekte zayıftır. “Kesinlikle”, “şüphesiz”, “her zaman” gibi ifadeler içeren yanıtlara karşı daha şüpheci ol. Gerçek dünyada çoğu konu bu kadar kesin değildir.

Pro İpucu: AI’a “Bu bilgiden ne kadar eminsin?” veya “Bu konuda belirsizlik var mı?” diye sorabilirsin. Bazı modeller bu şekilde daha dürüst yanıtlar verebilir.

Sıkça Sorulan Sorular

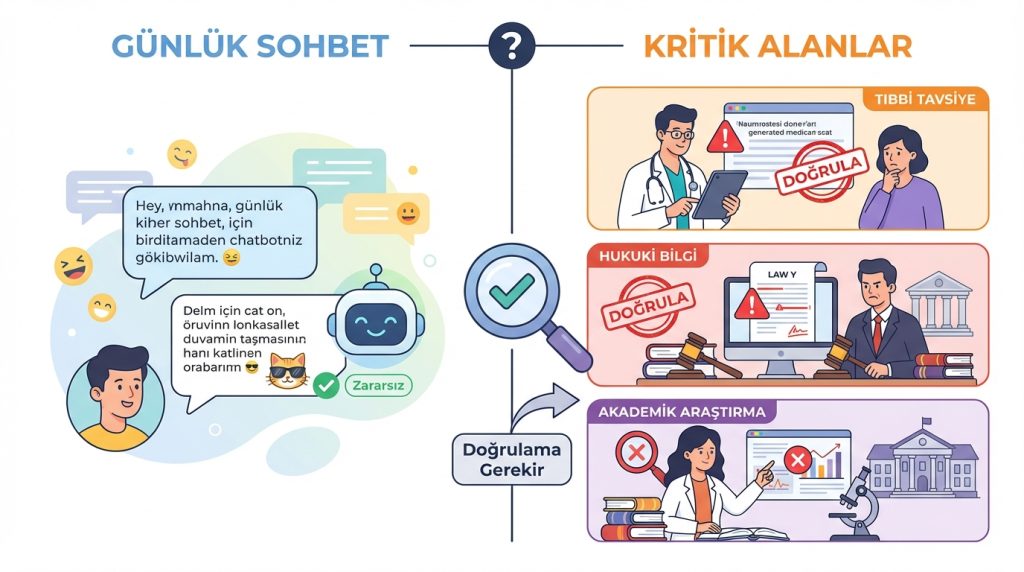

AI hallucination tehlikeli mi?

Bağlama göre değişir. Günlük sohbette zararsız olabilir, ancak tıbbi tavsiye, hukuki bilgi veya akademik araştırma gibi alanlarda yanlış bilgi ciddi sonuçlara yol açabilir. Bu yüzden kritik konularda AI yanıtlarını mutlaka doğrulamak gerekir.

Hangi AI modelleri daha az halüsinasyon üretir?

Genel olarak daha yeni ve büyük modeller, daha iyi eğitim teknikleri sayesinde halüsinasyon oranını azaltmış durumda. Ancak hiçbir model halüsinasyondan tamamen muaf değil. RAG (Retrieval-Augmented Generation) gibi tekniklerle desteklenen sistemler genellikle daha güvenilir sonuçlar verir.

AI’a “uydurma” demek doğru mu?

Teknik olarak AI kasıtlı olarak yalan söylemiyor; sadece olasılık hesabına dayalı çalışma mantığı nedeniyle yanlış bilgi üretebiliyor. “Halüsinasyon” terimi bu durumu tanımlamak için sektörde yaygın olarak kullanılıyor.

Halüsinasyonu tamamen önlemek mümkün mü?

Şu anki teknoloji ile tamamen önlemek mümkün değil. Ancak doğrulama alışkanlıkları geliştirmek, güvenilir kaynaklarla çapraz kontrol yapmak ve AI’ın sınırlarını bilmek riskleri önemli ölçüde azaltır.

AI yanıtlarını doğrulamak ne kadar zaman alır?

Basit bir çapraz kontrol birkaç dakika sürer. Kritik bilgiler için bu süreyi ayırmak, yanlış bilgiye dayalı kararlar almanın maliyetinden çok daha düşüktür.

Sonuç

AI hallucination, yapay zeka araçlarını kullanırken farkında olmamız gereken önemli bir sınırlama. Modeller ne kadar gelişmiş olursa olsun, ürettikleri her bilginin doğru olduğunu varsaymak riskli bir yaklaşım. Özellikle önemli kararlar alırken veya başkalarıyla paylaşacağın içerikler oluştururken, AI yanıtlarını doğrulama alışkanlığı edinmek şart.

Bu yazıdaki kontrol listesini kullanarak AI’dan aldığın bilgileri sistematik bir şekilde değerlendirebilirsin. Kaynakları kontrol et, tarihleri ve rakamları sorgula, çapraz kontrol yap ve modelin sınırlarını unutma. Bu adımları takip ettiğinde, yapay zeka araçlarından çok daha güvenli ve verimli bir şekilde faydalanabilirsin.

Cevap ver