Kurumsal belgeler arasında kaybolmak, özellikle binlerce sayfalık döküman arşiviyle uğraşırken kabus gibi hissedebilir. İşte tam bu noktada kurumsal dokümanlardan yanıt üreten ajan için RAG iş akışı kurma süreci devreye giriyor. Retrieval-Augmented Generation (RAG), büyük dil modellerinin (LLM) şirket içi verilerinize dayalı doğru ve kaynak gösterebilen yanıtlar üretmesini sağlayan bir mimari. Doğru kurulduğunda, çalışanlarınız saatlerce belge taramak yerine saniyeler içinde ihtiyaç duydukları bilgiye ulaşabiliyor.

Kilit Çıkarım: RAG, LLM’in “halüsinasyon” yapma riskini minimize ederken kurumsal bilgi tabanınızı akıllı bir asistana dönüştürür.

Başlamadan Önce

RAG pipeline’ı kurmaya başlamadan önce bazı hazırlıkları tamamlamanız gerekiyor. Eksik bir bileşen, ileride ciddi performans sorunlarına yol açabilir.

Gerekenler

- Python 3.9+ kurulu bir geliştirme ortamı

- LangChain veya LlamaIndex framework’ü

- Vektör veritabanı (Pinecone, Chroma, Weaviate veya Qdrant)

- OpenAI API anahtarı veya alternatif bir LLM erişimi

- Embedding modeli (text-embedding-ada-002 veya açık kaynak alternatifler)

Ön Koşullar

- Kurumsal belgelerinizin dijital formatta (PDF, DOCX, TXT) hazır olması

- Temel Python bilgisi

- API kullanımı hakkında genel anlayış

- Belgelerin hassasiyet seviyesine göre sınıflandırılmış olması

RAG Mimarisi: Temel Bileşenler

Bir RAG sistemi dört ana katmandan oluşur. Her katmanın doğru yapılandırılması, sistemin genel başarısını doğrudan etkiler.

1. Doküman İşleme Katmanı: Ham belgelerinizi sisteme besler, metin çıkarımı yapar ve chunking (parçalama) işlemini gerçekleştirir.

2. Embedding Katmanı: Metin parçalarını vektörlere dönüştürür. Bu vektörler, semantik benzerlik araması için kritik öneme sahip.

3. Retrieval (Getirme) Katmanı: Kullanıcı sorgusuna en uygun belge parçalarını vektör veritabanından çeker.

4. Generation (Üretim) Katmanı: LLM, getirilen bağlamı kullanarak doğal dilde yanıt üretir.

Adım Adım RAG Pipeline Kurulumu

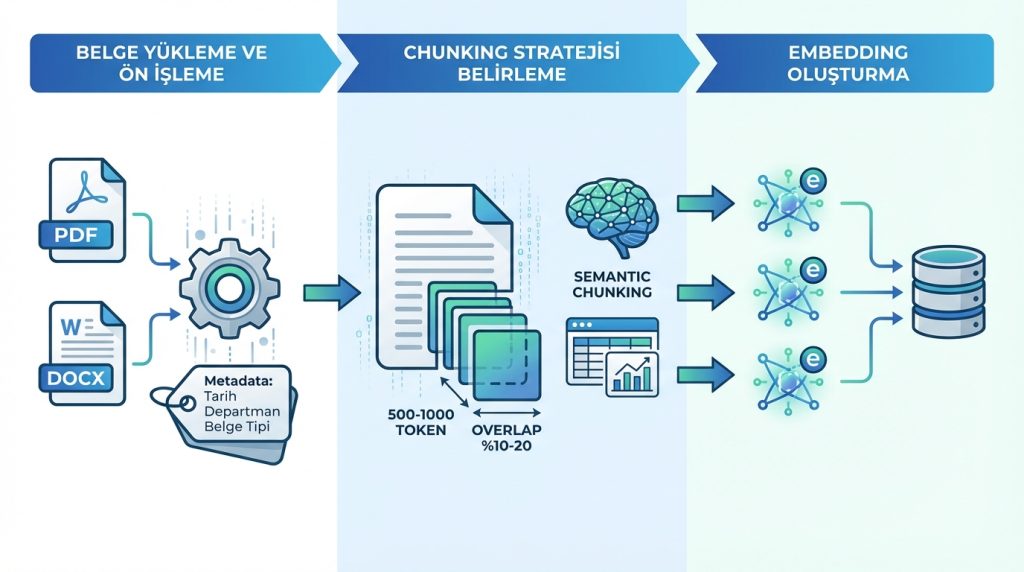

- Belge Yükleme ve Ön İşleme: Kurumsal dokümanlarını LangChain’in DocumentLoader sınıflarıyla yükle. PDF’ler için PyPDFLoader, Word dosyaları için Docx2txtLoader kullan. Metadata’yı (tarih, departman, belge tipi) mutlaka ekle.

- Chunking Stratejisi Belirleme: Belgeleri 500-1000 token aralığında parçalara böl. Overlap (örtüşme) değerini %10-20 arasında tut. Kurumsal raporlar için semantic chunking tercih et; tablolar ve finansal veriler için özel işleme uygula.

- Embedding Oluşturma: Her chunk için embedding vektörü oluştur. OpenAI’ın text-embedding-3-small modeli maliyet-performans dengesi için ideal. Açık kaynak tercih edersen, sentence-transformers kütüphanesinden all-MiniLM-L6-v2 modelini değerlendir.

- Vektör Veritabanına İndeksleme: Oluşturulan vektörleri seçtiğin veritabanına yükle. Metadata filtreleme özelliğini aktif et; bu sayede “sadece 2024 raporlarından ara” gibi sorgular mümkün olur.

- Retriever Yapılandırması: Similarity search için k değerini 3-5 arasında başlat. Hybrid search (vektör + keyword) kurumsal belgeler için daha isabetli sonuçlar veriyor.

- Ajan Entegrasyonu: LangChain Agent veya LangGraph kullanarak retriever’ı bir araç (tool) olarak tanımla. System prompt’ta ajanın rolünü ve yanıt formatını net belirle.

Pro İpucu: Chunking yaparken tablo ve liste yapılarını bölme. Finansal tablolar gibi yapısal verileri tek bir chunk olarak tut, aksi halde “2024 Q4 geliri” gibi sorularda LLM bağlamı kaybeder.

Vektör Veritabanı Karşılaştırması

Doğru vektör veritabanı seçimi, RAG sisteminin performansını ve ölçeklenebilirliğini belirler. Güncel karşılaştırmalara göre her seçeneğin kendine özgü avantajları var.

| Veritabanı | Kurulum Zorluğu | Ölçeklenebilirlik | Fiyatlandırma | En Uygun Senaryo |

|---|---|---|---|---|

| Pinecone | Kolay | Yüksek | Kullanıma göre | Kurumsal, production-ready projeler |

| Chroma | Çok Kolay | Orta | Ücretsiz (açık kaynak) | Prototipleme, küçük-orta projeler |

| Weaviate | Orta | Yüksek | Self-hosted ücretsiz | Hibrit arama gerektiren projeler |

| Qdrant | Orta | Yüksek | Self-hosted ücretsiz | Yüksek performans gerektiren uygulamalar |

| pgvector | Kolay | Orta | PostgreSQL maliyeti | Mevcut PostgreSQL altyapısı olanlar |

Maliyet Tahmini: Orta ölçekli bir kurumsal proje (100.000 belge) için Pinecone aylık $70-150 arasında maliyet çıkarırken, self-hosted Chroma veya Qdrant sadece sunucu maliyetine mal olur.

Chunking Stratejileri: Hangisi Ne Zaman?

Chunking, RAG performansının en kritik değişkenlerinden biri. Yanlış strateji, alakasız sonuçlar veya eksik bağlam anlamına gelir.

Fixed-size Chunking: Sabit karakter veya token sayısına göre böler. Basit ve hızlı ama anlam bütünlüğünü korumaz. Genel amaçlı belgeler için kabul edilebilir.

Semantic Chunking: Anlam bütünlüğüne göre doğal kırılma noktaları bulur. Kurumsal raporlar, politika belgeleri için ideal. Pratikte en sık tercih edilen yöntem bu.

Recursive Chunking: Önce büyük bölümlere, sonra alt bölümlere ayırır. Hiyerarşik yapıya sahip belgeler (el kitapları, teknik dokümanlar) için uygun.

Risk Seviyesi: Yanlış chunking stratejisi seçimi, retrieval doğruluğunu %40’a kadar düşürebilir. Testlerde farklı stratejileri karşılaştırarak en uygun olanı belirle.

Mini Senaryo: Şu Durumda Ne Yaparsın?

Diyelim ki RAG sisteminiz “2023 yılı personel politikası değişiklikleri nelerdir?” sorusuna alakasız yanıtlar veriyor. İlk kontrol noktaları:

- Chunk boyutu çok mu küçük? Bağlam kaybı olabilir.

- Metadata filtreleme aktif mi? Yıl bazlı filtreleme ekle.

- Embedding modeli Türkçe’yi iyi anlıyor mu? Multilingual model dene.

- Retriever’ın k değeri çok mu düşük? 5-7’ye çıkar.

Sıkça Sorulan Sorular

RAG sistemi için minimum kaç belge gerekli?

Teknik olarak tek bir belgeyle bile başlayabilirsiniz. Ancak anlamlı bir kurumsal asistan için en az 50-100 belgelik bir corpus önerilir. Önemli olan belge sayısından çok, içerik kalitesi ve çeşitliliği.

Türkçe belgeler için hangi embedding modeli tercih edilmeli?

OpenAI’ın text-embedding-3 serisi Türkçe’yi gayet iyi işliyor. Açık kaynak tercih ederseniz, multilingual-e5-large veya paraphrase-multilingual-MiniLM-L12-v2 modelleri güçlü alternatifler.

RAG sistemi hassas kurumsal verileri dışarı sızdırır mı?

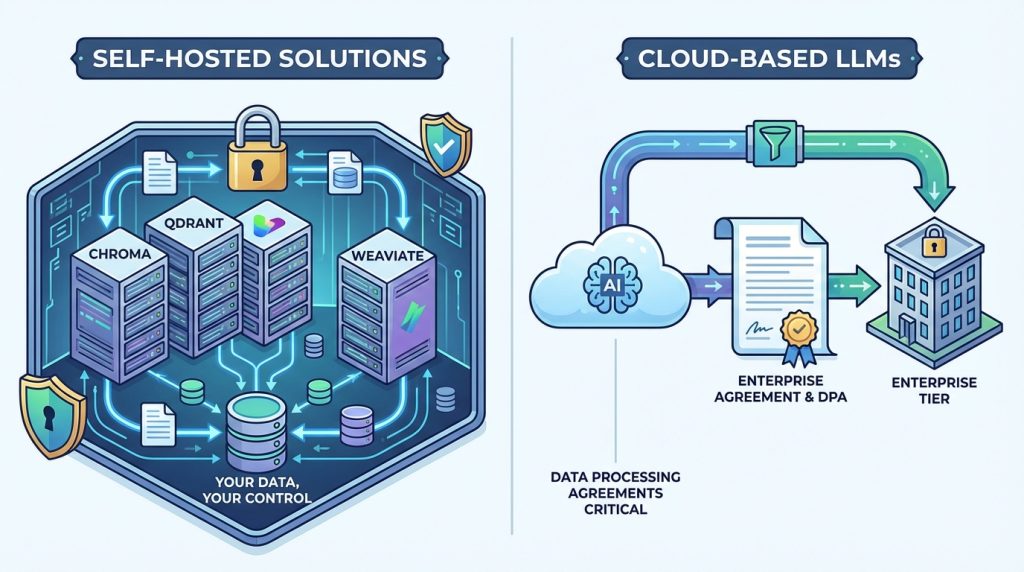

Self-hosted çözümler (Chroma, Qdrant, Weaviate) kullandığınızda veriler tamamen sizin kontrolünüzde kalır. Bulut tabanlı LLM’ler için enterprise tier anlaşmaları ve data processing agreement’lar kritik önem taşır.

Sistem ne sıklıkla güncellenmeli?

Belge değişiklik sıklığına bağlı. Dinamik içerikler için günlük veya haftalık incremental indexing, statik arşivler için aylık tam reindex yeterli.

Sonuç

Kurumsal dokümanlardan yanıt üreten bir RAG ajanı kurmak, doğru bileşenler ve stratejiyle düşündüğünüz kadar karmaşık değil. Başarının anahtarı üç noktada yatıyor: uygun chunking stratejisi seçimi, doğru vektör veritabanı tercihi ve sürekli test-optimizasyon döngüsü.

Prototip aşamasında Chroma ile başlayıp, production’a geçerken Pinecone veya self-hosted Qdrant’a migrate etmek yaygın ve mantıklı bir yol haritası. Unutmayın: mükemmel RAG sistemi ilk denemede ortaya çıkmaz. Kullanıcı geri bildirimleriyle iteratif iyileştirme, uzun vadeli başarının temelidir.

Sonraki Adım: Küçük bir belge setiyle (10-20 doküman) proof-of-concept oluşturun. Retrieval kalitesini manuel olarak test edin, ardından ölçeklendirmeye geçin.

Cevap ver