Log Yığınlarından Anlam Çıkarmak Artık Mümkün

Bir güvenlik ekibinde çalışıyorsanız veya DevOps/SRE rolündeyseniz şu sahneyi iyi bilirsiniz: Sabah 03:00’te alarm çalar, binlerce satır log karşınıza çıkar ve “hangisi gerçek tehdit, hangisi gürültü?” sorusu beyin yorgunluğuyla birleşir. İşte tam bu noktada log özetleme ve olay triage için AI ajanı workflow kavramı devreye giriyor. Büyük Dil Modelleri (LLM) veajan tabanlı otomasyon sayesinde, log analizi artık insan gözüyle tarama dönemini geride bırakıyor.

Kısa Tanım: AI ajanı workflow, birden fazla LLM destekli “ajan”ın belirli görevleri (log toplama, özetleme, önceliklendirme, aksiyon önerisi) sırayla veya paralel yürüttüğü bir otomasyon zinciridir. Amaç, ham log verisini saniyeler içinde eyleme dönüştürülebilir içgörüye çevirmektir.

Neden Geleneksel Log Analizi Artık Yetersiz?

Klasik SIEM araçları kural tabanlı çalışır: Önceden tanımlanmış regex kalıplarına uyan olayları yakalar, kalanını görmezden gelir. Ancak modern saldırılar ve mikro-servis mimarileri, bu yaklaşımın iki kritik açığını ortaya koyuyor:

- Alarm yorgunluğu: Günde binlerce “false positive” alarm, analistlerin dikkatinidağıtır.

- Bağlam körlüğü: Tek başına zararsız görünen olaylar, bir araya geldiğinde saldırı zincirioluşturabilir; kural tabanlı sistemler bu ilişkiyi kuramaz.

Araştırmalar, güvenlik operasyon merkezlerinde (SOC) analistlerin zamanının %70’ine yakınını “gürültü” ayıklamaya harcadığını gösteriyor. AI ajanı workflow’lar tam da bu noktada ezber bozucu bir çözüm sunuyor.

AI Ajanı Workflow Nasıl Çalışır?

Bir AI ajan zinciri tipik olarak üç katmandan oluşur. Her katman, bir sonrakine “temizlenmiş” veri aktarır:

1. Veri Toplama veÖn İşleme Ajanı

Farklı kaynaklardan (CloudWatch, Elasticsearch, Splunk, Syslog) logları çeker. Zaman damgası normalizasyonu, format birleştirme ve gereksiz alanların ayıklanması bu aşamada gerçekleşir.

2. Özetleme ve Bağlam Çıkarım Ajanı

LLM tabanlı buajan, binlerce satır logu birkaç paragraflık özete dönüştürür. Kritik olan nokta: Model sadece “ne oldu” değil, “bu neden önemli” sorusuna da yanıt verir. AWS’nin CloudWatch entegrasyonunda bu yaklaşım, triage süresini %60’a varan oranlarda kısalttığı raporlanıyor.

3. Triage ve Aksiyon Önerisi Ajanı

Özetlenen olayları önem derecesine göre sıralar (P1, P2, P3). Geçmiş olay verisiyle karşılaştırarak “budaha önce görüldü mü?”, “hangi playbook uygulanmalı?” sorularına yanıt üretir.

Kilit Çıkarım: Ajan zincirleri, tek bir monolitik model yerine uzmanlaşmış küçük modellerin orkestrasyonuyla çalıştığında hem maliyet hem doğruluk açısından avantaj sağlar.

Popüler Framework’ler ve Araçlar

2024 itibarıyla log analizi için AI ajanı workflow oluşturmak isteyenler genellikle şu framework’lere yöneliyor:

| Framework | Güçlü Yanı | Zayıf Yanı | Kullanım Alanı |

|---|---|---|---|

| LangChain / LangGraph | Geniş entegrasyon desteği, aktif topluluk | Öğrenme eğrisi dik | Karmaşık, çok adımlı workflow’lar |

| AutoGen (Microsoft) | Çoklu ajandiyalogları, kolay prototipleme | Üretim ortamındaölçekleme zorlukları | Araştırma vePoC projeleri |

| CrewAI | Rol tabanlı ajan tanımı, basit sözdizimi | Daha az olgun ekosistem | Hızlı MVP geliştirme |

| n8n + LLM Entegrasyonu | Görsel workflow tasarımı, düşük kod | Karmaşık mantık için sınırlı | Operasyon ekipleri, hızlı otomasyon |

Pro İpucu: Eğer ekibinizde Python deneyimi sınırlıysa, n8n gibi düşük kodlu platformlarla başlayıp zaman içinde LangGraph’a geçiş yapmakdaha sürdürülebilir bir strateji olabilir.

Adım Adım: Basit Bir Log Triage Workflow’u Kurma

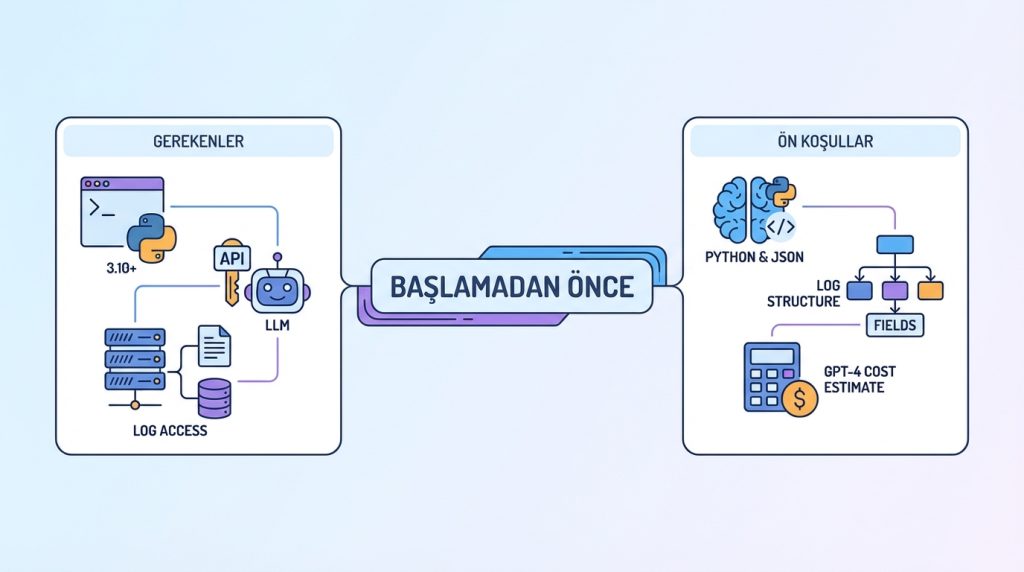

Başlamadan Önce

Gerekenler:

- Python 3.10+ yüklü bir ortam

- OpenAI API anahtarı veya yerel LLM (Ollama, LM Studio)

- Log kaynağına erişim (dosya, API veya veritabanı)

Ön Koşullar:

- Temel Python ve JSON bilgisi

- Log formatınızın yapısını anlama (hangi alanlar kritik?)

- Maliyet tahmini: GPT-4 kullanıyorsanız token başınaücretlendirmeyi hesaba katın

Kurulum Adımları

- Ortamı hazırla: Sanal ortam oluştur ve gerekli paketleri yükle.

pip install langchain openaikomutuyla temel bağımlılıkları kur. - Log kaynağını bağla: Dosya tabanlı bir başlangıç için JSON veya CSV formatında örnek log dosyası hazırla. Gerçek ortamda Elasticsearch veya CloudWatch bağlantısı ekleyebilirsin.

- Özetleme ajanını tanımla: Prompt mühendisliği burada kritik. Modelden “bu log grubundaki en kritik 3 olayı listele ve neden önemli olduklarını açıkla” gibi yapılandırılmış çıktıiste.

- Triage mantığını ekle: Özetleme çıktısını alan ikinci birajan tanımla. Bu ajan, önem derecesiataması yapacak ve önerilen aksiyon listesi üretecek.

- Çıktıyı yapılandır: Sonuçları Slack, e-posta veya ticketing sistemine (Jira, ServiceNow) gönderecek entegrasyonu kur.

Pro İpucu: İlk aşamada “insan onayı” adımı ekle. Model çıktılarını bir süre manueldoğrulayarak hangi durumlarda hata yaptığını öğren, ardından prompt’larınıiyileştir.

Yaygın Hatalar ve Kaçınılması Gerekenler

- Tüm logları LLM’e göndermek: Token maliyeti hızla tırmanır. Önce filtreleme ve örnekleme yap.

- Bağlam penceresini aşmak: GPT-4 Turbo128K token desteklese de, çok uzun girdiler halüsinasyon riskini artırır.

- Tek ajana fazla görev yüklemek: “Hem özetle hem analiz et hem aksiyon öner” demek yerine, her görevi ayrı bir ajana ver.

- Güvenlik açığı bırakmak: Log verisi hassas bilgi içerebilir. Yerel LLM veya şifreli API bağlantısı kullanmayı değerlendir.

Gerçek Dünya Senaryoları

Senaryo 1: Gece Yarısı Alarm Patlaması

Kubernetes cluster’ınızda 500 pod aynı anda “OOMKilled” hatası veriyor. Geleneksel yaklaşımda her pod’un logunu tek tek incelemeniz gerekir. AI ajanı workflow ile sistem, tüm hataları gruplayarak “memory limit aşımı, son deploy’dan sonra başladı, rollback öneriliyor” şeklinde tek satırlık özet sunar.

Senaryo 2: Güvenlik Olayı Triage

SOC ekibiniz günde 5.000 alarm alıyor. AI ajanı, MITRE ATT&CK framework’üyle eşleştirme yaparak “bu IP adresi daha önce 3 farklı müşteride görüldü, lateral movement belirtisi” gibi bağlamsal uyarılar üretir. Analist, 5.000 alarm yerine önceliklendirilmiş 50 olayla ilgilenir.

Maliyet ve Performans Değerlendirmesi

Maliyet: OpenAI API kullanıyorsanız, günlük 1 milyon satır log içinaylık 200-500 USD arası bütçe ayırmanız gerekebilir. Yerel LLM (Llama 3, Mistral) ile bu maliyet donanım yatırımınadönüşür ancak uzun vadededaha ekonomik olabilir.

Süre: İlk kurulum 1-2 hafta, olgunlaşma süreci 2-3 ay. Prompt optimizasyonu ve edge case’lerin keşfi zaman alır.

Risk Seviyesi: Orta. Yanlış önceliklendirme kritik bir olayın gözden kaçmasına neden olabilir. Bu nedenle ilk 3-6 ay “asistan” modunda çalıştırıp, tamamen otonom hale getirmeden önce doğruluk oranlarını ölçün.

Sıkça Sorulan Sorular

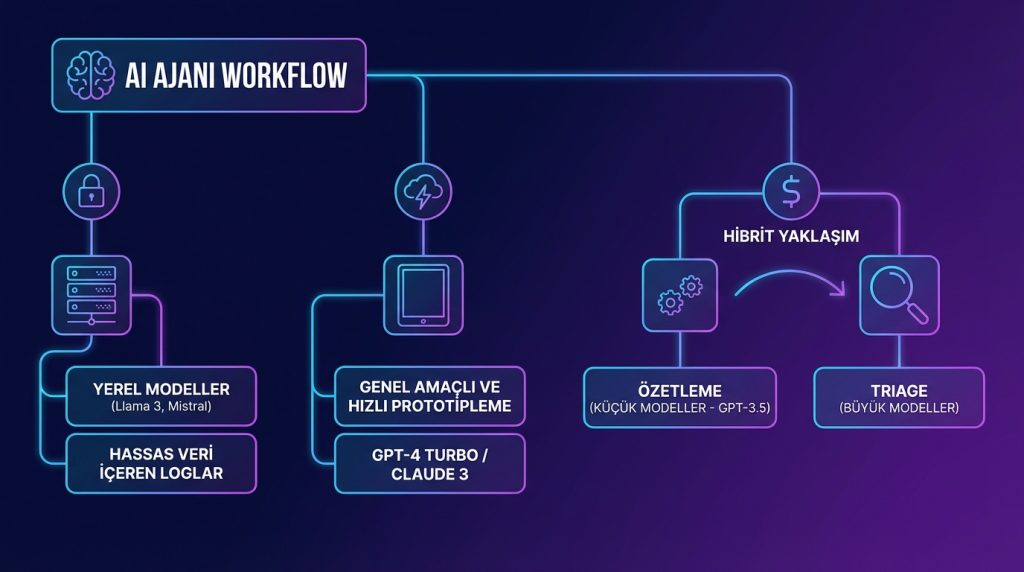

AI ajanı workflow için hangi LLM’i seçmeliyim?

Hassas veri içeren loglar için yerel modeller (Llama 3, Mistral) önerilir. Genel amaçlı ve hızlı prototipleme için GPT-4 Turbo veya Claude 3 iyi seçeneklerdir. Maliyet kritikse, özetleme için küçük modeller (GPT-3.5), triage için büyük modeller kullanarak hibrit yaklaşım deneyin.

Mevcut SIEM aracımla entegre edebilir miyim?

Evet. Splunk, Elastic SIEM ve Microsoft Sentinel gibi platformların çoğu API desteği sunar. AI ajanı workflow’u bu araçların “üstüne” bir katman olarak konumlandırabilirsiniz.

Halüsinasyon riski nasıl azaltılır?

Yapılandırılmış çıktı formatları (JSON şeması) kullanın. Modelden “emin değilsen’belirsiz’ yaz” talimatı verin. Kritik kararlar için çiftajandoğrulaması (birajan önerir, diğeri denetler) uygulayın.

Sonuç

Log özetleme ve olay triage için AI ajanı workflow’lar, güvenlik ve operasyon ekiplerinin iş yükünü radikal biçimde azaltma potansiyeli taşıyor. Ancak bu teknoloji sihirli değnek değil;doğru prompt mühendisliği, dikkatli maliyet yönetimi ve kademeli otomasyon stratejisi gerektiriyor.

Başlamak için küçük bir pilot projeyle yola çıkın: Tek bir log kaynağı, tek bir kullanım senaryosu. Sonuçlarıölçün, prompt’larınızı iyileştirin ve ardından kapsamı genişletin. Pratikte en sık görülen başarı hikayelerinin ortak noktası, “hızlı başla, yavaş ölçekle” stratejisidir.

Cevap ver